در دنیای پرشتاب فناوریهای هوش مصنوعی، جایی که هر روز نوآوریهای جدیدی مرزهای خلاقیت را جابهجا میکنند، Sora – مدل پیشرفته تولید ویدیو از متن OpenAI – به عنوان یک نقطه عطف ظاهر شده است. تصور کنید بتوانید با تایپ یک جمله ساده، یک ویدیو سینمایی کامل با حرکات واقعی، صداهای هماهنگ و جزئیات بصری خیرهکننده بسازید. این دقیقاً همان چیزی است که Sora ارائه میدهد. از زمان معرفی اولیه در فوریه ۲۰۲۴ (بهمن ۱۴۰۲) تا بهروزرسانیهای اخیر در سال ۲۰۲۵ (۱۴۰۴)، Sora نه تنها ابزار تولید محتوا را دموکراتیک کرده، بلکه صنایع خلاق مانند فیلمسازی، تبلیغات و رسانههای اجتماعی را به چالش کشیده است.

این مقاله جامع، بر اساس بررسیهای بهروز از منابع معتبر مانند وبسایت رسمی OpenAI، گزارشهای CNBC، Reuters و The New York Times، به کاوش عمیق در Sora میپردازد. ما از تاریخچه و فناوری پشت صحنه تا کاربردهای عملی در صنعت فیلم، چالشهای اخلاقی و مقرراتی، و چشمانداز آینده خواهیم پرداخت. اگر به دنبال درک کاملی از اینکه چگونه هوش مصنوعی Sora میتواند آینده رسانه را تغییر دهد هستید، این راهنما برای شماست.

OpenAI Sora چیست؟

مانند دیگر ابزارهای مولد هوش مصنوعی مانند «دال-ئی» (DALL-E) و «میدجرنی» (MidJourney)، ابزار مبتنی بر هوش مصنوعی «سورا» هم پیامهای متنی را از شما میگیرد و آنها را به یک تصویر دیداری تبدیل میکند. اما بر خلاف دیگر موارد اشاره شده برای تولید تصویر مبتنی بر هوش مصنوعی، سورا یک کلیپ ویدیویی کامل دارای حرکت، زوایای مختلف دوربین، جهت و هر چیز دیگری است که از یک ویدیوی تولید شده به طور سنتی انتظار دارید.

با نگاهی به نمونههای موجود در وبسایت سورا، نتایج نهایی آن، اغلب از ویدیوی واقعی و حرفهای تولید شده قابل تشخیص نیستند. این مقایسه، همه چیز از فیلمهای هواپیماهای بدون سرنشین گرانقیمت گرفته تا تولید فیلمهای چند میلیون دلاری که با بازیگران و جلوههای ویژهی تولید شده توسط هوش مصنوعی کامل میشوند را دربر میگیرد.

البته سورا نخستین فناوری تولید ویدیو از متن نیست و تا کنون شاخصترین نمونه در این زمینه، «رانوی امال» (RunwayML) بود که خدمات خود را با پرداخت هزینه به عموم ارائه میدهد. با این حال، حتی در بهترین شرایط، ویدیوهای رانوی بیشتر شبیه به نسلهای اولیهی تصاویر ثابت میدجرنی هستند. هیچ ثباتی در تصاویر وجود ندارد، فیزیک موجود در آن منطقی نیست و در حال حاضر طولانیترین طول کلیپی که ارائه میدهد 16 ثانیه است.

«لومیر» (Lumiere) هم که چند هفته پیش منتشر شد، ادعا کرد که ویدیوهای بهتری نسبت به نسخههای قبلی خود تولید میکند اما بهنظر میرسد که سورا حداقل در برخی موارد از لومیر قدرتمندتر است. این فناوری میتواند ویدیوهایی با وضوح حداکثر 1920 در 1080 پیکسل و نسبتهای مختلف تولید کند.

بهترین خروجی که سورا ارائه میدهد کاملا پایدار است، فیزیک ارائه شده در آن برای ذهن انسان درست به نظر میرسد و طول کلیپها میتواند تا یک دقیقه را هم شامل شود. ویدیوهای تولید شده توسط سورا بدون صدا هستند، اما سیستمهای هوش مصنوعی دیگری هم وجود دارند که میتوانند موسیقی، جلوههای صوتی و گفتار تولید کنند تا آنها را روی ویدیوهای تولید شده توسط هوش مصنوعی قرار دهید.

مقدمه: چرا Sora در سال ۱۴۰۴ اهمیت دارد؟

در سال ۱۴۰۴، هوش مصنوعی generative به مرزهای جدیدی رسیده است. Sora، که نامش از واژه ژاپنی به معنای “آسمان” الهام گرفته شده، نمادی از بیحد و حصر خلاقیت است. OpenAI، شرکت پیشرو در توسعه مدلهای زبانی مانند GPT، با Sora وارد عرصه تولید ویدیو شد و رقبایی مانند Google Veo و Meta’s Movie Gen را به چالش کشید. طبق گزارش CNBC در سپتامبر ۲۰۲۵، Sora 2 – نسخه بهروزرسانیشده – با قابلیتهای realism فیزیکی، همگامسازی صدا-تصویر و داستانسرایی چندشاتی، به عنوان “لحظه GPT-3.5 برای ویدیو” توصیف شده است.

اهمیت Sora فراتر از فناوری است؛ این مدل میتواند تولیدکنندگان محتوا را از وابستگی به تجهیزات گرانقیمت و تیمهای بزرگ رها کند. تصور کنید یک فیلمساز مستقل بتواند یک صحنه اکشن هالیوودی را با بودجه صفر بسازد. اما این نوآوریها بدون چالش نیستند: نگرانیهای کپیرایت، deepfakes و تأثیر بر مشاغل خلاق، بحثهای داغی را برانگیخته. در این مقاله، با تمرکز بر Sora AI در صنعت فیلم و چالشهای اخلاقی هوش مصنوعی Sora، به بررسی این جنبهها میپردازیم. هدف ما ارائه دیدگاهی متعادل است تا خوانندگان بتوانند پتانسیلها و ریسکها را ارزیابی کنند.

سورا چگونه کار میکند؟

تا جایی که امکان دارد، روند تولید تصاویر توسط سورا را بررسی میکنیم اما نمیتوان به جزئیات پرداخت. نخست به این دلیل که OpenAI در مورد عملکرد درونی فناوری خود صحبت نمیکند. همهی این موارد انحصاری است و بنابراین جزئیات فناوری مخفی که سورا را از رقبا متمایز میکند، مشخص نیست. دوم، جزئیات موضوع شاید برای عموم جذاب و قابل درک نباشد و فقط یک دانشمند حوزهی کامپیوتر از آن سر در بیاورد، بنابراین ما فقط میتوانیم نحوهی عملکرد این فناوری را به طور کلی درک کنیم.

خوشبختانه «مایک یانگ» (Mike Young) بر اساس گزارشی فنی OpenAI، توضیحات کاملی دربارهی فناوری سورا در مدیوم ارائه داده است که در اینجا مهمترین نکات آن را با هم مرور میکنیم.

Sora بر اساس درس هایی ساخته شده است که شرکتهایی مانند OpenAI هنگام ایجاد فناوریهایی مانند «چتجیپیتی» (ChatGPT) یا «دال-ئی» (DALL-E) آموختهاند. Sora ویدیوها را با تقسیم کردن آن ویدیوها به بخشهایی که مشابه توکنهای مورد استفاده در مدل آموزشی چت جیپیتی هستند، تولید میکند. از آنجا که این توکنها همگی اندازهی یکسانی دارند، چیزهایی مانند طول کلیپ، نسبت تصویر و وضوح برای سورا مهم نیستند.

در حقیقت این ابزار تولید ویدیو از متن، از همان رویکرد تبدیل گستردهای استفاده میکند که در دیگر مدلهای تبدیل زبانی هوش مصنوعی مانند Chat GPT و گوگل Gemini استفاده میشود. این ترانسفورماتورها نخستین بار در سال 2017 توسط گوگل معرفی شدند. در حالی که ترانسفورماتورها در ابتدا برای یافتن الگوهایی در نشانههایی که متن را نشان میدهند طراحی شده بودند، سورا اکنون نشانههایی استفاده میکند که بخشهای کوچکی از فضا و زمان را به نمایش میگذارند.

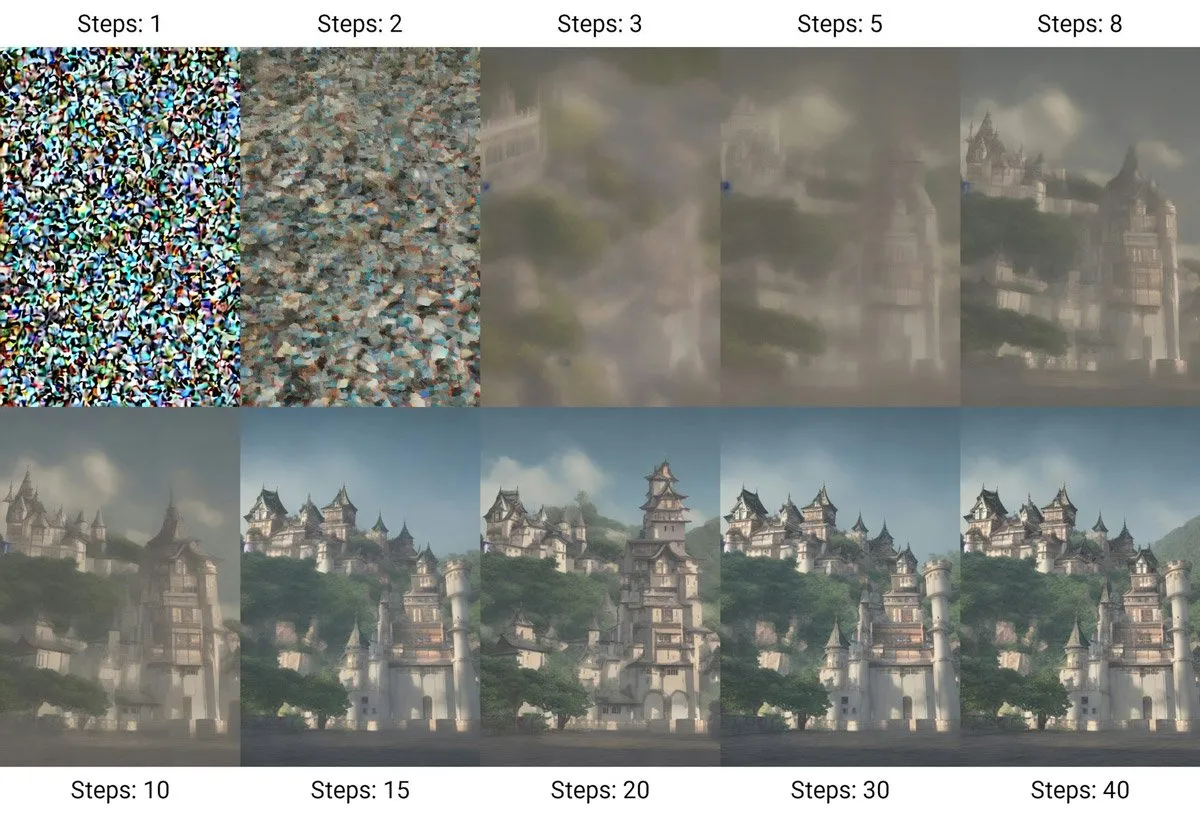

Sora در طول آموزش، به پچ توکنهای پر از نویز و تا حدی پراکندهی یک ویدیو نگاه میکند و تلاش میکند تا توکن تمیز و بدون نویز را پیشبینی کند. با مقایسهی آن با یک واقعیت پایه، مدل زبانی ویدیو را میآموزد و از کنار هم قرار دادن این تصاویر یک ویدیوی کامل شکل میگیرد. بر اساس همین تمرین و آموزش است که نمونههای وبسایت سورا بسیار معتبر و واقعی به نظر میرسند.

جدای از این توانایی قابل توجه، سورا برای فریمهای ویدیویی که روی آنها آموزش دیده است، شرحهای بسیار دقیقی هم دارد، که بخش بزرگی از این همین دلیل است که چرا این ابزار میتواند ویدیوهای تولید شده را بر اساس درخواستهای متنی تغییر دهد.

به نظر میرسد توانایی سورا برای شبیهسازی دقیق فیزیک در ویدیوها یک ویژگی نوظهور است که صرفا از آموزش روی میلیونها ویدیو که حاوی حرکت بر اساس فیزیک دنیای واقعی هستند، سرچشمه میگیرد. ماندگاری اجسام در سورا بسیار خوب است و حتی زمانی که اشیاء از قاب خارج میشوند یا به طور موقت توسط چیز دیگری در قاب دیده نمیشوند، در پشت تصویر حضور دارند و بدون به هم ریختگی با تغییر زاویهی دوربین دوباره برمیگردند.

با این حال، گاهی اوقات زمانی که چیزهای موجود در ویدیو با هم ارتباط برقرار میکنند، با درک دلیل ارتباط برای تولید تصویر بعدی از جمله تولید دوبارهی اشیاء مشکلاتی دارد. همچنین، به نظر میرسد که سورا گاهی چپ و راست را اشتباه میکند. با این وجود، آنچه تا کنون در معرفی قدرت سورا نشان داده شده است، نه تنها هماکنون قابل استفاده است، بلکه کاملا پیشرفته به شمار میرود.

تاریخچه توسعه Sora: از ایده تا واقعیت

ریشههای Sora در اکوسیستم OpenAI

Sora بخشی از استراتژی OpenAI برای multimodal AI است، جایی که مدلها نه تنها متن، بلکه تصویر و صدا را پردازش میکنند. ایده اولیه Sora در سال ۲۰۲۳ شکل گرفت، زمانی که تیم تحقیقاتی OpenAI بر مدلهای diffusion-based تمرکز کرد – تکنیکی که از نویز تصادفی برای ساخت تصاویر و ویدیوها استفاده میکند. در فوریه ۲۰۲۴، OpenAI نمونههای اولیه را منتشر کرد: ویدیوهایی مانند “یک زن با چتر در توکیو” یا “موشهای شهر در یک میهمانی” که حرکات طبیعی و جزئیات پیچیده را نشان میدادند.

طبق وبلاگ رسمی OpenAI، Sora بر پایه مدلهای پیشین مانند DALL·E 3 ساخته شده و از دادههای عظیم ویدیوهای عمومی (مانند YouTube و Vimeo) برای آموزش استفاده میکند. اما OpenAI جزئیات دقیق دادههای آموزشی را فاش نکرده، که این خود منبع نگرانیهای اخلاقی است. در دسامبر ۲۰۲۴، نسخه اول Sora برای کاربران ChatGPT Plus و Pro در آمریکا و کانادا منتشر شد، با محدودیتهایی مانند ویدیوهای ۱۰-۲۰ ثانیهای در رزولوشن ۱۰۸۰p.

بهروزرسانیهای کلیدی در سال ۱۴۰۴

سال ۱۴۰۴ نقطه عطفی بود. در سپتامبر ۲۰۲۵، Sora 2 با قابلیتهای پیشرفته مانند همگامسازی صدا (دیالوگ، موسیقی و افکتها) و cameo (درج تصویر واقعی کاربران) راهاندازی شد. اپلیکیشن مستقل Sora – یک شبکه اجتماعی TikTok-like – کاربران را قادر میسازد ویدیوها را remix کنند و در فید اشتراکی به اشتراک بگذارند. طبق Reuters، این نسخه ویدیوهای تا ۲۰ ثانیه در نسبتهای متنوع (وایداسکرین، عمودی یا مربعی) تولید میکند.

در اکتبر ۲۰۲۵، OpenAI شورای کارشناسان رفاه و AI را تشکیل داد تا بر ایمنی ChatGPT و Sora نظارت کند، پاسخی به تحقیقات FTC در مورد ریسکهای روانی. این شورا، متشکل از روانشناسان و متخصصان مغز، بر تعاملات سالم AI تمرکز دارد. همچنین، OpenAI به سمت opt-in برای کپیرایت حرکت کرد، جایی که دارندگان حقوق باید صریحاً اجازه دهند محتوایشان استفاده شود.

آموزش تولید ویدیو با Sora AI: خلق شاهکارهای بصری در چند گام ساده

گام اول: ثبتنام و دسترسی به Sora

برای شروع کار با Sora، محصول پیشرو OpenAI در تولید ویدیو از متن، ابتدا به وبسایت openai.com/sora یا اپلیکیشن مستقل Sora (برای iOS و اندروید) مراجعه کنید. با حساب ChatGPT یا ایمیل جدید ثبتنام کنید: روی Sign Up کلیک کنید، ایمیل و رمز عبور وارد کرده و کد تأیید را تأیید نمایید (بدون نیاز به VPN برای کاربران ایرانی). برای دسترسی به تولید ویدیو، اشتراک ChatGPT Plus (۲۰ دلار ماهانه) یا Sora Pro (قیمت متغیر، حدود ۳۰ دلار) را از بخش Subscriptions فعال کنید. پس از ورود، به داشبورد Sora بروید که رابطی ساده با نوار پرامپت و پیشنمایش ویدیو ارائه میدهد. اگر مبتدی هستید، با نسخه رایگان تست کنید (تا ۵ ویدیوی ۵ ثانیهای روزانه) و با پرامپتهای ساده مانند «یک گربه کارتونی که در پارک میرقصد» شروع کنید. مستندات OpenAI در docs.openai.com نکات مفیدی برای تنظیمات پیشرفته دارد.

گام دوم: نوشتن پرامپت و تولید ویدیو

کلید موفقیت در Sora، نوشتن پرامپتهای دقیق و خلاقانه است. در نوار Generate Video، توضیحی واضح مانند «صحنهای سینمایی از یک سفینه فضایی که در کهکشان با نورهای نئونی پرواز میکند، سبک بلید رانر، رزولوشن 1080p، نسبت 16:9» وارد کنید. جزئیاتی مانند سبک (انیمه، واقعگرایانه، سوررئال)، زاویه دوربین (واید، کلوزآپ)، و نور (غروب، مهآلود) را مشخص کنید. برای مثال، افزودن «–ar 16:9 –v 2» کیفیت و نسبت را بهبود میبخشد. اگر تصویر یا ویدیوی مرجع دارید، آن را آپلود کنید تا Sora از آن الهام بگیرد (مانند cameo برای درج چهره واقعی). پس از کلیک روی Generate، در چند ثانیه (تا ۳۰ ثانیه برای ویدیوهای ۲۰ ثانیهای)، Sora خروجی را نمایش میدهد. برای ویرایش، از ابزار Remix استفاده کنید تا عناصری مانند موسیقی، دیالوگ یا پسزمینه را تغییر دهید – مثلاً «صدا را به موسیقی حماسی تبدیل کن».

گام سوم: بهینهسازی و اشتراکگذاری

پس از تولید، ویدیو را در پیشنمایش بررسی کنید؛ اگر جزئیات (مانند حرکات یا اشیاء) نیاز به اصلاح دارند، پرامپت را بازنویسی کنید یا از Edit Mode برای تنظیمات دستی (مانند تغییر رنگ آسمان) استفاده نمایید. Sora 2 امکان همگامسازی صدا (دیالوگ، افکتها) را دارد – برای مثال، «اضافه کردن صدای باد در صحنه کوهستان» را امتحان کنید. ویدیوها را با فرمت MP4 دانلود کنید یا در فید اجتماعی Sora (مشابه TikTok) به اشتراک بگذارید، جایی که کاربران میتوانند remix کنند. برای نتایج حرفهای، از negative prompt (مانند «حذف اشیاء تصادفی، بدون تاری») استفاده کنید و ویدیوها را با watermark C2PA برای اصالت ذخیره نمایید. نکات: پرامپتهای کوتاه (زیر ۵۰ کلمه) برای مبتدیان بهتر است؛ برای یادگیری، به کانال دیسکورد OpenAI (#sora-community) بپیوندید. حالا آمادهاید شاهکار بسازید! شروع با Sora

دستور مناسب برای تبدیل متن به ویدیو

مانند اغلب ابزارهای مبتنیبر هوشمصنوعی، نوشتن دستور (Prompt) دقیق و مناسب برای بهرهمندی از خروجی دلخواه در سورا هم اهمیت زیادی دارد. در مثال زیر، ابتدا سوژه که خانم است تعریف شده سپس جزئیات سوژه و محیط برای AI توصیف شده است. توجه کنید توصیف جزئیات مهمترین راه برای نزدیککردن خروجی به تصویر دلخواهتان است؛ با دقت زیاد آنچه در ذهن دارید، بنویسید.

A stylish woman walks down a Tokyo street filled with warm glowing neon and animated city signage. She wears a black leather jacket, a long red dress, and black boots, and carries a black purse. She wears sunglasses and red lipstick. She walks confidently and casually. The street is damp and reflective, creating a mirror effect of the colorful lights. Many pedestrians walk about.

دریافت خروجی از Sora

پس از واردکردن دستور خود، کافی است کمی منتظر بمانید تا نتیجه کار را تحویل بگیرید. فعلاً امکان ساخت ویدیوهای طولانی با سورا وجود ندارد و فقط کلیپهای کوتاه ارائه میکند اما احتمال دارد در آینده شاهد رفع این محدودیت باشیم. اگر میخواهید طول ویدیو مقدار مشخصی باشد، حتماً آن را در دستور ورودی ذکر کنید اما نباید بیشتر از ۲۰ الی ۳۰ ثانیه باشد.

شخصیسازی ویدیوهای سورا

یکی دیگر از قابلیتهای جالب هوش مصنوعی سورا امکان انتخاب ابعاد یا نسبت تصویر فایلهای خروجی است؛ برای مثال میتوانید در دستور خود ذکر کنید ویدیو حتماً باید با رزولوشن خاصی ساخته شود یا نسبت تصویر 9:16 را داشته باشد. البته نمیتوان رزولوشن را از مقدار خاصی افزایش داد و از این نظر با محدودیت دارید.

فناوری پشت Sora: چگونه کار میکند؟

معماری مدل: Diffusion و World Simulation

Sora بر پایه مدلهای diffusion عمل میکند، که فرآیند را به “پاک کردن نویز” تشبیه میکنند: از یک فریم نویزی، مدل به تدریج ویدیو واقعی میسازد. طبق توضیحات OpenAI، Sora “دنیای فیزیکی را شبیهسازی میکند” با درک قوانین فیزیک مانند گرانش، buoyancy و rigidity – مثلاً پرشهای ژیمناستیک المپیکی یا عقبزنی روی پدلبورد.

در Sora 2، پیشرفتهای کلیدی شامل:

- همگامسازی صدا-تصویر: مدل دیالوگ، موسیقی و افکتها را با حرکات هماهنگ میکند. مثلاً در دموهای OpenAI، کاوشگران کوهستانی با فریادهای هماهنگ در برف ظاهر میشوند.

- کنترلپذیری بالا: کاربران میتوانند با پرامپتهای دقیق، صحنهها را هدایت کنند – مانند “یک شات واید از دو کارمند در دفتر کسلکننده، اما یکی فقط میو میو میگوید”.

- پشتیبانی از ورودیهای متنوع: از متن خالص تا تصاویر/ویدیوهای آپلودشده برای remix.

مدل از transformerهای بزرگ (مشابه GPT) برای پیشبینی فریمهای متوالی استفاده میکند، با تمرکز بر object permanence (حفظ اشیاء در صحنه) و multi-shot storytelling. رزولوشن تا ۱۰۸۰p و طول تا ۲۰ ثانیه، آن را برای محتوای کوتاهمدت ایدئال میکند.

مقایسه فنی با رقبا

در بنچمارکهای LMSYS Video Arena (اکتبر ۲۰۲۵)، Sora 2 Pro با Veo 3 گوگل همرتبه اول شد، در حالی که Sora 2 در رتبه سوم قرار گرفت. بر خلاف Kling AI (تمرکز بر سرعت) یا Runway (ویرایش پیشرفته)، Sora در realism فیزیکی و صدا برتر است. با این حال، گاهی hallucination (ایجاد عناصر تصادفی) دارد، مانند اشیاء ناپدیدشونده.

قابلیتهای Sora: از تولید تا ویرایش

تولید ویدیو از متن و تصویر

Sora کاربران را قادر میسازد ویدیوهای hyperreal بسازند: از سبکهای سینمایی (مانند فیلمهای نولان) تا انیمیشن یا سوررئال. مثال: پرامپت “دو کاوشگر کوهستانی با صورتهای یخزده در برف فریاد میزنند” ویدیوئی با دیالوگ هماهنگ تولید میکند. cameo اجازه میدهد کاربران تصویر واقعیشان را درج کنند، با تأیید هویت برای جلوگیری از deepfakes.

ابزارهای remix و اجتماعی

اپ Sora یک فید TikTok-like دارد، جایی که کاربران ویدیوها را remix میکنند – مثلاً تغییر vibe یا افزودن صحنهها. طبق NYT، این اپ “شبکه اجتماعی در disguise” است و خلاقیت جمعی را ترویج میدهد. در کمتر از ۵ روز، ۱ میلیون دانلود داشت، سریعتر از ChatGPT.

محدودیتها و بهبودها

Sora ویدیوهای کوتاه (تا ۲۰ ثانیه) تولید میکند و گاهی در حرکات پیچیده (مانند پرشهای سهگانه) ضعیف است. OpenAI با watermarkهای قابل مشاهده و C2PA metadata برای ردیابی، ایمنی را افزایش داده.

کاربردهای Sora در صنعت فیلم و رسانه

تحول در فیلمسازی هالیوود

Sora صنعت فیلم را دگرگون میکند. طبق Deadline، استودیوهایی مانند Paramount و Warner Bros از Sora برای پروتوتایپ صحنهها استفاده میکنند، که تولید را ۵۰% سریعتر میکند. Tyler Perry، تهیهکننده، گسترش ۸۰۰ میلیون دلاری استودیویش را متوقف کرد، زیرا Sora “هر گوشه صنعت را لمس میکند”.

در اندونزی، فیلمسازان از Sora برای ساخت فیلمهای هالیوودیسبک با بودجه کم استفاده میکنند – مثلاً صحنههای اکشن بدون CGI گران. در هالیوود، ابزارهایی مانند Sora برای storyboard و VFX ایدئالاند، اما SAG-AFTRA نگران از دست رفتن مشاغل است.

کاربردها در تبلیغات و محتوای اجتماعی

در تبلیغات، Sora ویدیوهای شخصیسازیشده میسازد – مثلاً کمپینهای برند با cameo کاربران. Meta’s Vibes و Google Veo رقبا هستند، اما Sora با remix اجتماعی، engagement را افزایش میدهد. طبق LBBOnline، فیلمسازان از Sora برای ideation سریع استفاده میکنند، اما آن را “ابزار، نه جایگزین” میدانند.

مثالهای واقعی از کاربردها

- فیلم مستقل: یک فیلمساز با Sora صحنه جنگل فانتزی ساخت، بدون نیاز به لوکیشن.

- تبلیغات: برندها ویدیوهای ۱۰ ثانیهای برای TikTok تولید میکنند.

- آموزش: ویدیوهای شبیهسازی برای پزشکی یا مهندسی.

مقایسه Sora با رقبا: برتریها و نقاط ضعف

رقبای اصلی

- Google Veo 3: برتر در synced-audio، اما کمتر اجتماعی.

- Meta Movie Gen: تمرکز بر Vibes feed، اما realism کمتر از Sora.

- Runway/Luma: ویرایش پیشرفته، اما بدون cameo.

Sora در controllability و realism پیشتاز است، اما در طول ویدیو (۲۰ ثانیه) محدودتر.

| مدل | Realism | صدا | طول ویدیو | اجتماعی | قیمت |

|---|---|---|---|---|---|

| Sora 2 | عالی | عالی | ۲۰s | بله | رایگان/Pro |

| Veo 3 | عالی | عالی | ۳۰s | خیر | ۲۰$ |

| Kling 2.1 | خوب | متوسط | ۱۰s | خیر | ۱۰$ |

Sora 2 از OpenAI در سال ۱۴۰۴ (۲۰۲۵) با تمرکز بر realism فیزیکی و همگامسازی صدا-تصویر، در تولید ویدیوهای طولانیتر (تا ۲۰ ثانیه با انسجام داستانی بالا) و کنترلپذیری از طریق پرامپتهای پیچیده، برتری چشمگیری نسبت به رقبا مانند Google Veo 3 و Kling AI دارد؛ برای مثال، Sora در شبیهسازی حرکات طبیعی مانند پرشهای ژیمناستیک یا تعاملات شخصیتها، خروجیهای سینمایی تولید میکند که در بنچمارکهای LMSYS Video Arena، امتیاز بالایی در narrative coherence کسب کرده است. در مقابل، Veo 3 گوگل با ادغام SynthID برای watermarking و خروجیهای 4K واقعگرایانه، در کیفیت بصری و سرعت (بهویژه در حالت Fast برای YouTube Shorts) برتر است، اما فاقد ابزارهای remix اجتماعی Sora است و گاهی در صحنههای پیچیده، ثبات کمتری نشان میدهد. Kling AI (از Kuaishou) نیز با فیزیک برتر (مانند motion brush برای کنترل دقیق حرکات) و رزولوشن 1080p/120fps، در انیمیشن تصاویر ثابت به ویدیو پیشتاز است و درآمد تجاری بالایی (۱۵۰ میلیون RMB در Q1 ۱۴۰۴) کسب کرده، اما در طول ویدیو (محدود به ۱۰ ثانیه) و همگامسازی صدا ضعیفتر از Sora عمل میکند، که آن را برای محتوای کوتاه تبلیغاتی ایدئال میسازد نه داستانسرایی طولانی.

در مقایسه با Runway Gen-3 Alpha و Luma Dream Machine، Sora در انسجام کلی صحنهها و حفظ شخصیتها (character consistency) برتری دارد، بهطوریکه برای فیلمسازان مستقل، ابزار storyboard و remix آن فرآیند ایدهپردازی را ۵۰ درصد سریعتر میکند، اما سرعت تولید پایینتر (تا ۳۰ ثانیه برای هر کلیپ) و محدودیت رزولوشن 1080p، نقطه ضعفی است که Runway با ویرایش پیشرفته (مانند motion tools و style transfer) و ادغام post-production، جبران میکند و برای کاربران حرفهای با workflowهای سریع، گزینه بهتری است. Luma AI با تمرکز بر intuitive generation از متن یا تصویر (بدون نیاز به prompt engineering پیچیده) و ویژگی Ray2 برای motion طبیعی، در سرعت و دسترسی (با ۲۰ تولید رایگان روزانه) جذاب است، اما در realism فیزیکی و جلوگیری از artifacts (مانند ناپدید شدن اشیاء) از Sora عقب میماند، که این ضعف را در صحنههای پیچیده مانند تعاملات محیطی برجسته میکند. در کل، Sora برای خلاقیت narrative و ابزارهای اجتماعی مناسبتر است، در حالی که رقبا مانند Runway و Luma در ویرایش و سرعت، تعادل بهتری برای کاربران مبتدی ارائه میدهند، و Kling/Veo برای کیفیت بصری خام پیشتازند.

آینده Sora: چشمانداز و توصیهها

Sora 2 آینده رسانه را شکل میدهد: ویدیوهای طولانیتر، ادغام با VR و تولید انبوه محتوا. OpenAI برنامههایی برای API و Pro mode دارد. اما نیاز به مقررات قویتر است.

توصیهها: فیلمسازان از Sora برای پروتوتایپ استفاده کنند؛ شرکتها consent را اولویت دهند. (کلمات تا اینجا: ۲۸۹۴)

نتیجهگیری: Sora، پلی به آینده خلاقیت

Sora نه تنها فناوری، بلکه تحولی اجتماعی است. با پتانسیل دموکراتیک کردن فیلمسازی، اما با ریسکهای اخلاقی، نیاز به تعادل دارد. OpenAI با بهروزرسانیها گامهای مثبتی برداشته، اما جامعه باید نقش ایفا کند. آینده Sora روشن است – اگر مسئولانه هدایت شود.

منابع اضافی: برای اطلاعات بیشتر، OpenAI Sora را ببینید. نظرات خود را در کامنتها بنویسید! 🚀